人型インタフェース

Embodied Conversational Agents

ジェスチャー

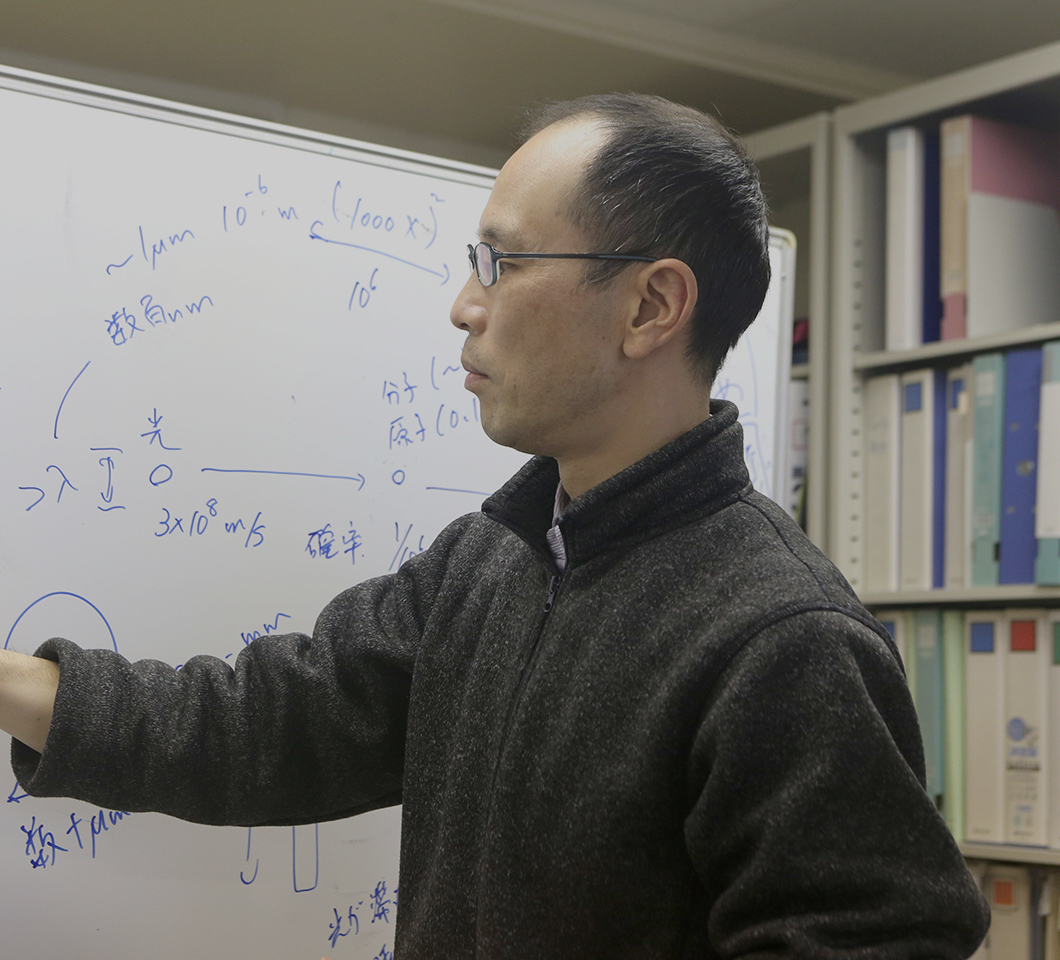

工学部 生命工学科

長谷川 大准教授

Dai Hasegawa

CGキャラクターが先生に未来の教育環境を構想する

人間が質問するとCGのキャラクターが流暢に答えるーーSFの世界ではよく見る光景ですが、人間とコンピュータがコミュニケーションを交わすことを情報工学では、「ヒューマン・コンピュータ・インタラクション(HCI)」と呼びます。気鋭のHCI研究者である長谷川先生は、〝先生ロボット〟が活躍する未来の教育を構想しています。

- 人間はどうやって言語を獲得しているのか

- 学生時代は情報工学における「自然言語処理」の研究室に属していたという長谷川先生。ちなみに「自然言語」とは、私たち人間が普段使っている言葉のことです。

「人間の言葉をコンピュータに処理させる研究をしている研究室だったんですが、私は、むしろ言語そのものに興味があったんです。特に人間はどうやって言語を理解し、使えるようになるのかという〝言語獲得〟のプロセスがメインテーマですね」

当時は、人間の言語獲得のプロセスにおいて、言葉そのもの以外に、「身体」が果たす役割が重要であることが認識され始めた頃だったといいます。

「例えば『手を挙げてください』という言葉がありますが、その意味するところを本当に理解するためには、身体が必要になってくる。つまり、こうやって手を上げる動作とセットとなって、その意味を理解していくわけです」

そこで、長谷川先生は指導教官のアドバイスを受けて、「人間が言語を獲得する過程をコンピュータを使って再現する」という研究を手掛けるようになります。

「人間とロボットがやりとりしていく中で、ロボットが新しい言語を自動的に学んで、さらに自主的に使えるようになるにはどうしたらいいか、ということを考えていました。私としては、この研究で博士論文を書こうと目論んでいたんですが、やっぱりそんな簡単なことじゃなかったんです」

- アメリカ留学で見つけた研究の「突破口」

- 博士論文を前に「かなりの足踏み状態」になってしまったという長谷川先生は、指導教官の後押しもあり、新たな視点を求めて半年間のアメリカ留学に出ます。

「留学先の大学で出会った先生が、まさにHCIを専門にされていたんですが、ロボットではなくて、CG(コンピュータグラフィックス)のキャラクターと人間とのコミュニケーションを先駆的に研究していた人だったんです」

この出会いが、難航していた長谷川先生の研究を展開させる「突破口」となります。

「それまでは人間がロボットとやり取りする中で、ロボットが言語を覚えていく、というシミュレーションに拘っていたんですが、そもそも言葉を教えるという行為自体がある種の相互作用、つまりインタラクションであり、そこからノイズのように生じる関係性があるのではないか、と発想を変えたんです。具体的には『ロボットに言葉を教えた人間は、そのロボットに対して親近感が湧きやすい』という話にテーマをチェンジして、これは幸いうまくいきました」

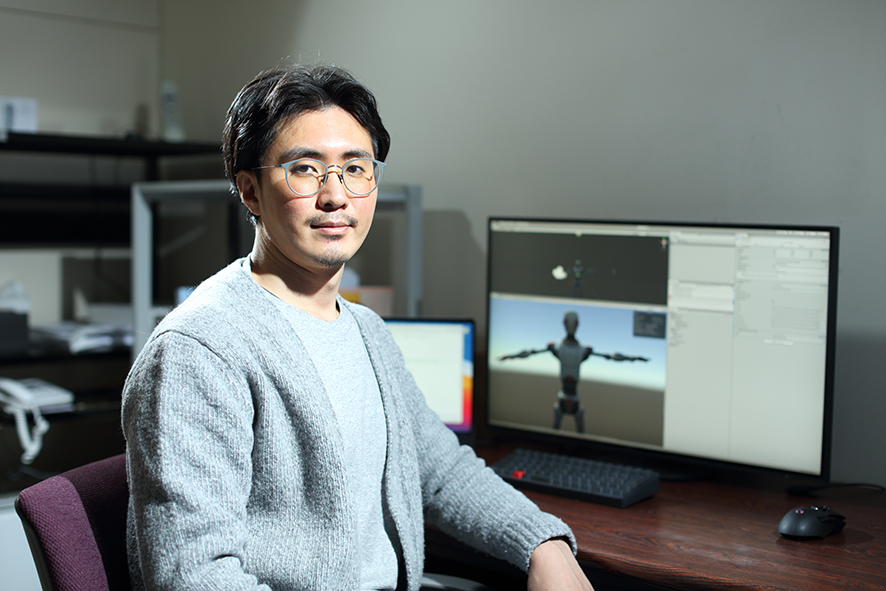

その長谷川先生が現在、取り組んでいるのが、「教師役のCGキャラクター(Pedagogical Agent)」を用いたオンラインでの教育環境の構想です。

「簡単にいうと、人間とコンピュータを繋ぐ新しいインタフェース(装置)として、人間同様のコミュニケーションができるCGの〝先生ロボット〟を作ろうとしています」

- ジェスチャーがもたらす「没入感」

- 人間同士のコミュニケーションにおいては、言語情報よりも、相手のジェスチャーや表情といった非言語情報から多くの情報を得ていると言われています。

「〝先生ロボット〟が〝生徒〟である人間に対して、ジェスチャーなどの非言語情報を駆使して教えることができれば、あたかも人間の先生に教えてもらっているかのような『没入感』をもって、学習することができるはずなんです」

長谷川先生はこの仮説を証明するため、実際にCGの〝先生ロボット〟の講義を学生に聞いてもらい、ジェスチャーの有無で理解度に差が出るかの比較を実施しました。

「講義後に内容を踏まえたテストを行ったところ、ジェスチャー『あり』の講義を受けた学生のほうが、『なし』の学生よりも、理解度が高くなる傾向がありました」

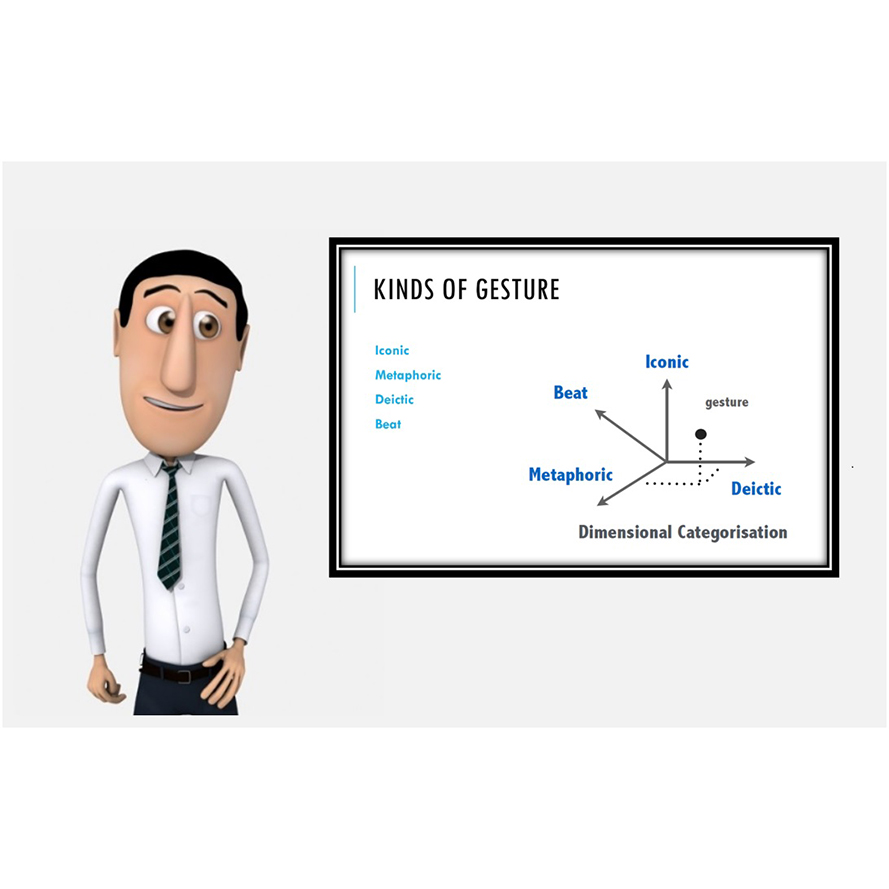

もっとも、人間の発する言葉とジェスチャーの組み合わせは無限にあり、すべて網羅することは非現実的です。そこで長谷川先生は、ジェスチャーの種類に着目します。

「ジェスチャーには大きく分けると具体的なものと抽象的なものがあります。前者は例えば、モノの大きさとか形を手で表現するもので、これは無限にあります。一方で後者は、抽象的な概念を三次元に写像するジェスチャー、例えば、『繰り返します』と言いながら指で連続した丸を描くとか、ですね。前後の文脈の影響をあまり受けず、その種類も限られるので、いまは、この抽象的ジェスチャーに集中しています」

音声から自動生成されたジェスチャー

- 「先生ロボット」だからできること

- 今は、音声をインプットすると、ロボットがそれにあわせたジェスチャーをする自動生成の仕組みを作っているところですが、課題は少なくないようです。

「一番大きいのは、CGのロボットに動きをつけるのは、もの凄く手間がかかるんです。手を上げるだけでも、どのタイミングでどう上げるか、ということを細かくプログラミングする必要があるからです。これを何とか簡易化したい」

言うまでもなく人間の先生であれば、そうした設定作業は必要ありません。では、「先生ロボット」のメリットは、どこにあるのでしょうか。

「ひとつには、一度『先生ロボット』が完成してしまえば、非常に低コストで稼働できます。また、学習者が『学びたい』タイミングで、いつでもどこでも何度でもインタラクティブな授業を受けることができる。また『教える内容や順序』をマークアップランゲージで記述するように工夫することで、誰でも『先生ロボット』による学習教材を作れるようになります。学習者同士で教材を作りあうような新しい学習環境をつくることもできるかもしれません」

将来的には、パソコンのカメラ機能などで、学習者の表情などをモニタリングして「理解度」を判断し、それに応じて〝先生ロボット〟が説明の仕方を変えるというところまで考えられています。未来では「学び教える楽しさ」もまた進化していきます。

- Profile

-

工学部 生命工学科

長谷川 大北海道旭川市生まれ。北海道大学大学院情報科学研究科メディアネットワーク専攻博士後期課程修了。博士(情報科学)。人間でもコンピュータでもないその境界について考えるのがHuman Computer Interactionという分野です。これまでにマウスやGUIなど様々な境界(インタフェース)が発明されてきましたが、もっと多様な可能性があるはずです。次世代の人間とコンピュータの境界について研究しています。『Moving Fast and Slow: Analysis of Representations and Post-Processing in Speech-Driven Automatic Gesture Generation』(International Journal of Human-Computer Interaction、2021年)ほか、論文多数。

Other Interview